Narzędzie do wykrywania filmów wygenerowanych przez AI

Naukowcy z Columbia Engineering opracowali narzędzie DIVID, które z 93,7% skutecznością wykrywa filmy generowane przez sztuczną inteligencję.

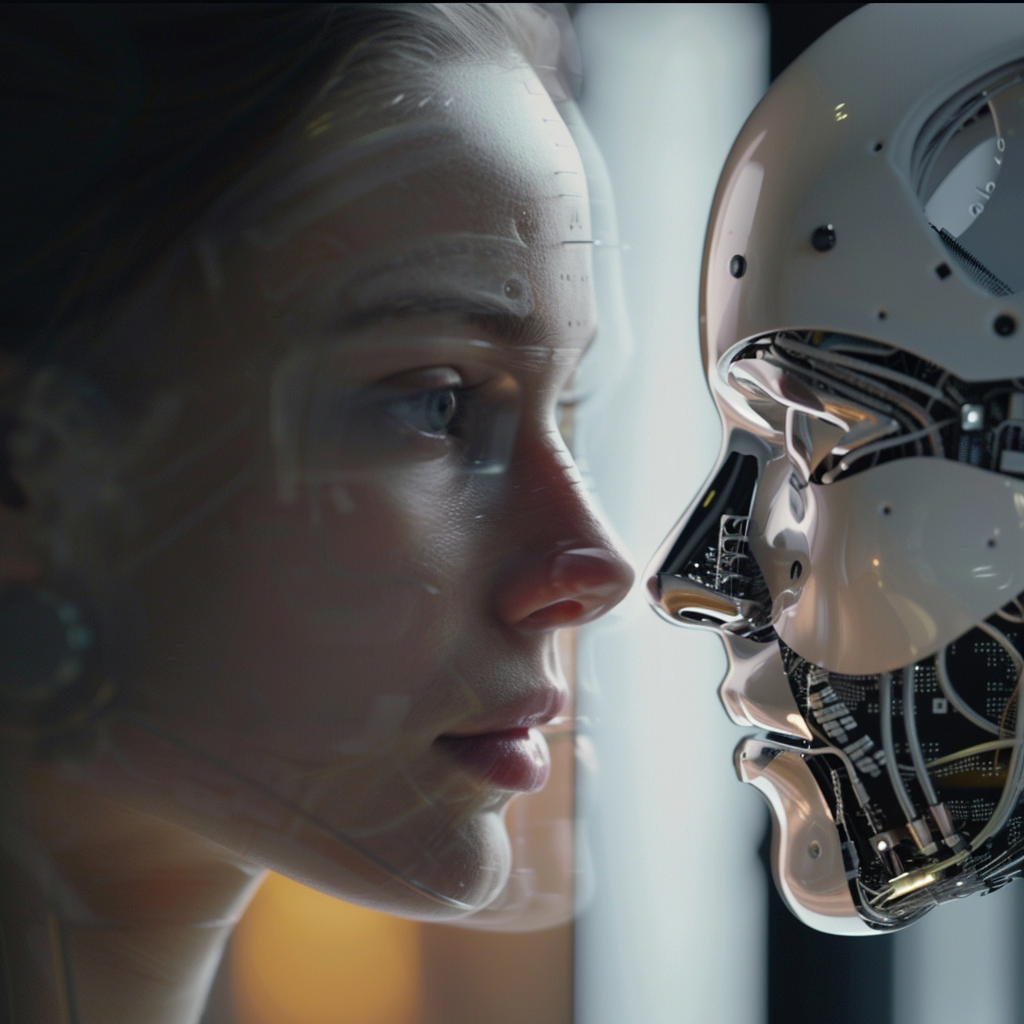

Na początku tego roku międzynarodowa korporacja padła ofiarą wyrafinowanego oszustwa, w ramach którego pracownik przekazał oszustom 25 milionów dolarów.

Pracownik wierzył, że instrukcje pochodzą bezpośrednio od dyrektora finansowego firmy, ale przestępcy wykorzystali sztuczną inteligencję do stworzenia realistycznych filmów przedstawiających dyrektora finansowego i innych współpracowników w celu realizacji planu.

Realizm wygenerowanych filmów za pomocą sztucznej inteligencji osiągnął poziom, na którym nawet ludzie i istniejące systemy wykrywania AI, mają trudności z odróżnieniem ich od prawdziwych filmów. Aby rozwiązać ten problem, naukowcy z Columbia Engineering, kierowani przez profesora informatyki Junfenga Yanga, opracowali narzędzie o nazwie DIVID (DIffusion-generated Video Detector). Narzędzie to jest rozwinięciem ich wcześniejszych prac nad wykrywaniem tekstu generowanego przez sztuczną inteligencję, znanego jako Raidar, który analizuje tekst bez konieczności rozumienia wewnętrznego działania dużych modeli językowych.

DIVID został zaprojektowany do wykrywania filmów generowanych przez nowe modele sztucznej inteligencji, w szczególności te wykorzystujące modele dyfuzyjne, które są bardziej zaawansowane niż starsze modele, takie jak generatywne sieci przeciwstawne (GAN). Sieci GAN składają się z dwóch sieci neuronowych: jednej, która tworzy fałszywe dane i drugiej, która je ocenia, stale ulepszając obie, aż do uzyskania bardzo realistycznych syntetycznych filmów. Tradycyjne narzędzia do wykrywania sztucznej inteligencji szukają anomalii, takich jak dziwne wzory pikseli, nienaturalne ruchy lub niespójności między klatkami, które nie występują w filmach stworzonych sposobem klasycznym.

Jednak nowsze generatywne narzędzia tworzące wideo przy pomocy AI, takie jak Sora firmy OpenAI, Runway Gen-2 i Pika, wykorzystują modele dyfuzyjne. Modele tworzą obrazy i filmy, stopniowo przekształcając losowy szum w wyraźne, realistyczne obrazy. W przypadku filmów każda klatka jest dopracowywana indywidualnie, zapewniając jednocześnie płynne przejścia, co skutkuje wysokiej jakości, realistycznymi wynikami. To wyrafinowanie sprawia, że wykrycie ich autentyczności stanowi wyzwanie.

Zespół Yanga wykorzystuje technikę o nazwie DIRE (DIffusion Reconstruction Error) do wykrywania obrazów generowanych przez dyfuzję. DIRE mierzy różnice między obrazem wejściowym a zrekonstruowanym obrazem wyjściowym za pomocą wstępnie wyszkolonego modelu dyfuzyjnego.

Yang i jego zespół badali sposoby wykrywania tekstu i filmów generowanych przez sztuczną inteligencję. Ich wcześniejsze narzędzie, Raidar, wykrywa tekst generowany przez sztuczną inteligencję, analizując sam tekst, bez konieczności uzyskiwania dostępu do wewnętrznego działania dużych modeli językowych, takich jak ChatGPT-4, Gemini lub Llama. Raidar przeformułowuje lub zmienia dany tekst i mierzy zakres tych zmian. Wiele zmian wskazuje na tekst napisany przez człowieka, podczas gdy mniej zmian sugeruje tekst wygenerowany maszynowo.

„Wgląd w Raidar – że wyniki AI są często postrzegane jako wysokiej jakości przez inne AI, co skutkuje mniejszą liczbą edycji – jest potężny i wykracza poza tekst” – powiedział Yang. „Biorąc pod uwagę rosnący realizm filmów generowanych przez sztuczną inteligencję, chcieliśmy zastosować tę wiedzę do stworzenia narzędzia, które dokładnie wykrywa filmy generowane przez sztuczną inteligencję”.

Korzystając z tej samej zasady, zespół opracował DIVID do identyfikacji filmów generowanych przez modele dyfuzyjne. Badania, w tym kod open source i zbiory danych, zostały zaprezentowane na konferencji Computer Vision and Pattern Recognition Conference (CVPR) w Seattle 18 czerwca 2024 r.

DIVID działa poprzez rekonstrukcję wideo i porównanie nowo zrekonstruowanej wersji z oryginałem. Wykorzystuje wartości DIRE do wykrywania filmów generowanych przez dyfuzję w oparciu o hipotezę, że obrazy generowane przez modele dyfuzyjne powinny być do siebie bardzo podobne, biorąc pod uwagę, że są próbkowane z rozkładu procesu dyfuzji. Znaczące różnice sugerują, że wideo zostało stworzone przez człowieka, podczas gdy niewielkie różnice wskazują, że zostało wygenerowane przez sztuczną inteligencję.

Ramy działają w oparciu o koncepcję, że treści generowane przez sztuczną inteligencję mają tendencję do podążania za wzorcami statystycznymi pochodzącymi z dużych zbiorów danych, co skutkuje subtelnymi niespójnościami lub błędami w klatkach wideo. Cechy te różnią się od filmów tworzonych przez ludzi, które wykazują większą indywidualność i odbiegają od norm statystycznych. DIVID osiągnął imponującą dokładność 93,7% w wykrywaniu filmów generowanych przez dyfuzję z wzorcowego zestawu danych, w tym Stable Vision Diffusion, Sora, Pika i Gen-2.

Obecnie DIVID jest narzędziem wiersza poleceń dla programistów, wskazującym, czy wideo jest generowane przez sztuczną inteligencję, czy przez człowieka. Naukowcy badają potencjalne integracje, takie jak wtyczka Zoom do wykrywania fałszywych połączeń w czasie rzeczywistym, a także opracowują stronę internetową lub wtyczkę do przeglądarki, aby udostępnić DIVID publicznie.

„Nasze ramy są znaczącym krokiem naprzód w wykrywaniu treści generowanych przez sztuczną inteligencję” – powiedział Yun-Yun Tsai, jeden z autorów artykułu i doktorant Yang. „Kluczowe znaczenie ma powstrzymanie oszustów korzystających z filmów generowanych przez sztuczną inteligencję i ochrona społeczeństwa”.

Zespół pracuje nad ulepszeniem DIVID, aby obsługiwał różne syntetyczne filmy z narzędzi do generowania open source. Używają również DIVID do kompilowania filmów do zbioru danych DIVID, mając na celu zwiększenie skuteczności i zakresu narzędzia w wykrywaniu oszustw.

Szymon Ślubowski